Önceki sinirsel net golf zorlukları ( şu ve bu ) yeni bir meydan okumaya ilham verdi:

Meydan okuma

da tamsayı girişleri olan herhangi bir 4 boyutlu giriş vektörü verildiğinde, ağın kesinlikle daha küçük bir koordinat açısından hata .

kabul edilebilirlik

Bu zorluk için, ileri beslemeli bir sinir ağı tabakaların bir bileşimi olarak tanımlanır . Bir tabaka bir fonksiyonudur , bir matris tarafından belirtilen ve ağırlıkları , bir vektör arasında yanlılık ve bir aktivasyon fonksiyonu koordinat damla tatbik edilir:

Etkinleştirme işlevleri herhangi bir görev için ayarlanabildiğinden, bu zorluğu ilginç tutmak için etkinleştirme işlevleri sınıfını kısıtlamamız gerekir. Aşağıdaki etkinleştirme işlevlerine izin verilir:

Kimlik.

Relu.

SOFTPLUS.

Hiperbolik tanjant.

Sigmoid.

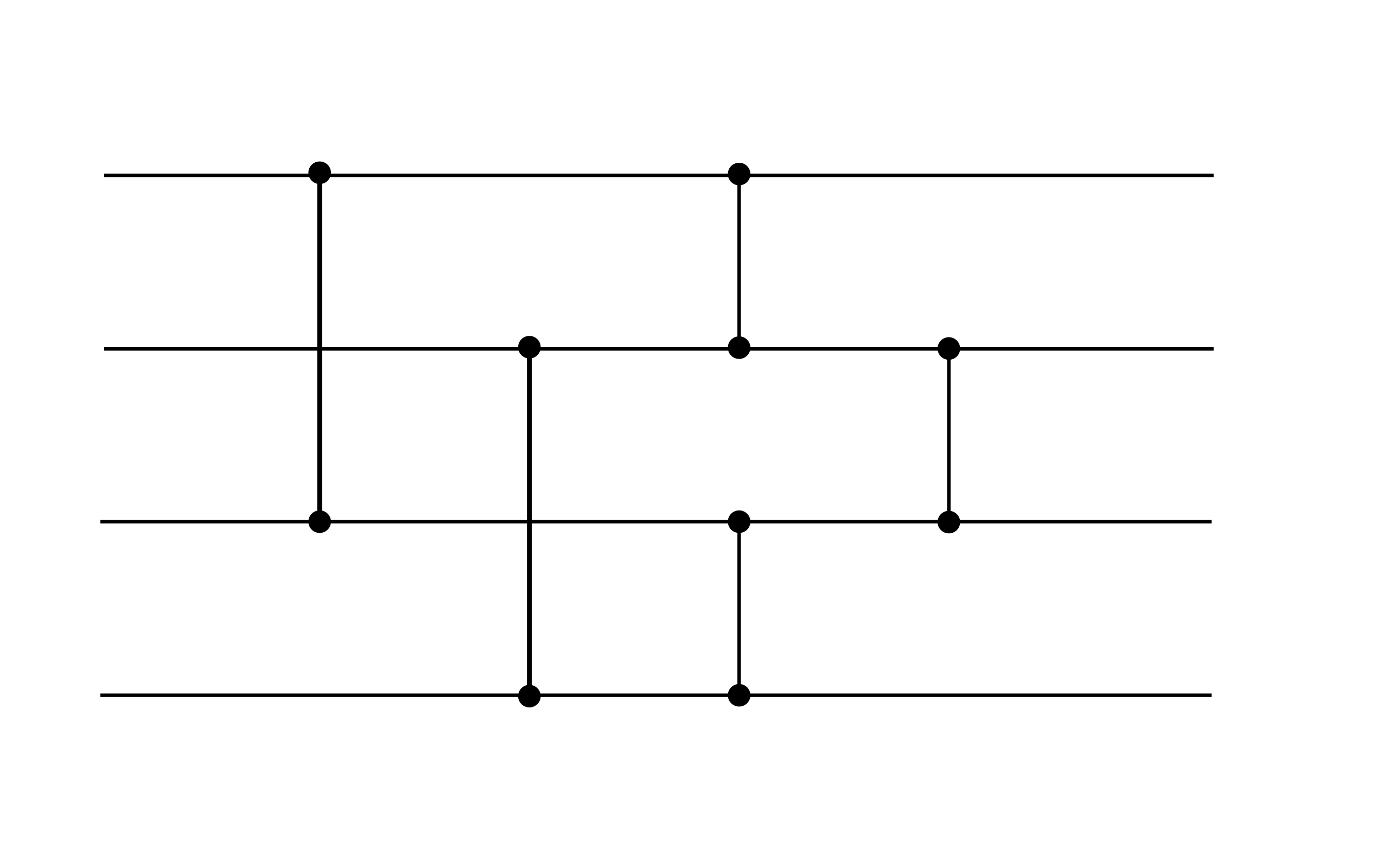

Genel olarak, kabul edilebilir bir sinirsel ağ şeklini alır bazı her bir katman, ağırlıkları ile belirlenir yanlılıklar , ve bir aktivasyon fonksiyonu Yukarıdaki listeden. Örneğin, aşağıdaki sinir ağı kabul edilebilir (bu zorluğun performans hedefini karşılamasa da, yararlı bir gadget olabilir):

Bu örnekte iki katman gösterilmektedir. Her iki katmanın da sıfır sapması vardır. İlk katman ReLU aktivasyonunu kullanırken, ikinci katman kimlik aktivasyonunu kullanır.

puanlama

Puanınız, sıfır olmayan ağırlık ve önyargıların toplam sayısıdır .

(Örneğin, yukarıdaki örnekte sapma vektörleri sıfır olduğu için 16 puanı vardır.)